Aufgabe:

Ziel des Projekts ist die Entwicklung von mobilen Applikationen zur Visualisierung georeferenzierter Objektdaten auf mobilen Endgeräten. Die geeignete Visualisierung von zusätzlichen Informationen im Sichtbereich von Benutzern ist immer noch eine herausfordernde Aufgabe. Die geolokalisierten Daten eines Objekts werden hierbei im Kamerabild eines mobilen Endgeräts visualisiert. Ein wichtiger Aspekt der mobilen Applikation besteht darin, dass sie flexibel auf die gegeben Zustände eingehen muss.

Lösungskonzept:

Durch die Analyse von aktuellen Standpunkt- und Sensordaten ist es möglich, das mobile Endgerät in Beziehung mit dem gesuchten Objekt zu bringen. So wird, um ein gutes Ergebnis zu erzielen, in Abhängigkeit der Distanz zum Objekt das optimale Visualisierungsverfahren gewählt. Hierfür wird neben der allgemeinen Sensorik (Beschleunigungsmesser, Gyroskop etc.) auch die Kamerasensorik ausgewertet.

Im Zuge des Projekts wurden eigene Apps entwickelt, die die Möglichkeit bieten, sowohl das mobile Endgerät zu kalibrieren als auch die Unsicherheit der intern genutzten Sensoren zu bestimmen.

Für die Darstellung des Objekts benötigt das mobile Endgerät hierbei nur die Position des Objekts und ggf. ein Bild von diesem.

Die Position des mobilen Endgeräts, welche für die Objektvisualisierung bekannt sein muss, kann durch verschiedene Verfahren ermittelt werden:

- GPS

- Fusionierung der Lokalisierungsinformationen: Hierbei werden WLAN-, Mobilfunknetz- und GPS-Informationen fusioniert, um den Positionierungsfehler zu minimieren.

- Manuelle Auswahl in Google Maps.

- Lokalisierung durch ein vorher erzeugtes georeferenziertes Deskriptorenset.

In Abhängigkeit der Distanz und der gegebenen Objektinformationen kann das Objekt visualisiert werden. Hierfür können verschiedene Visualisierungstechniken flexibel eingesetzt werden:

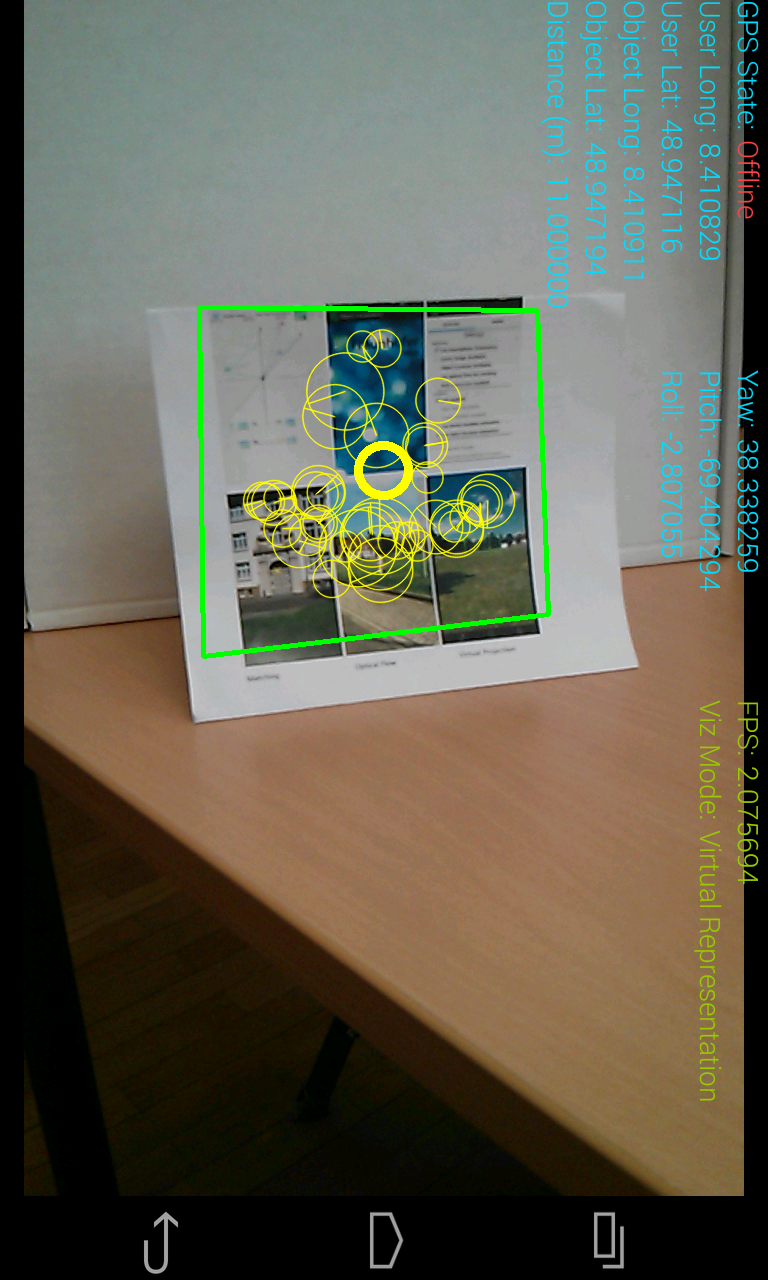

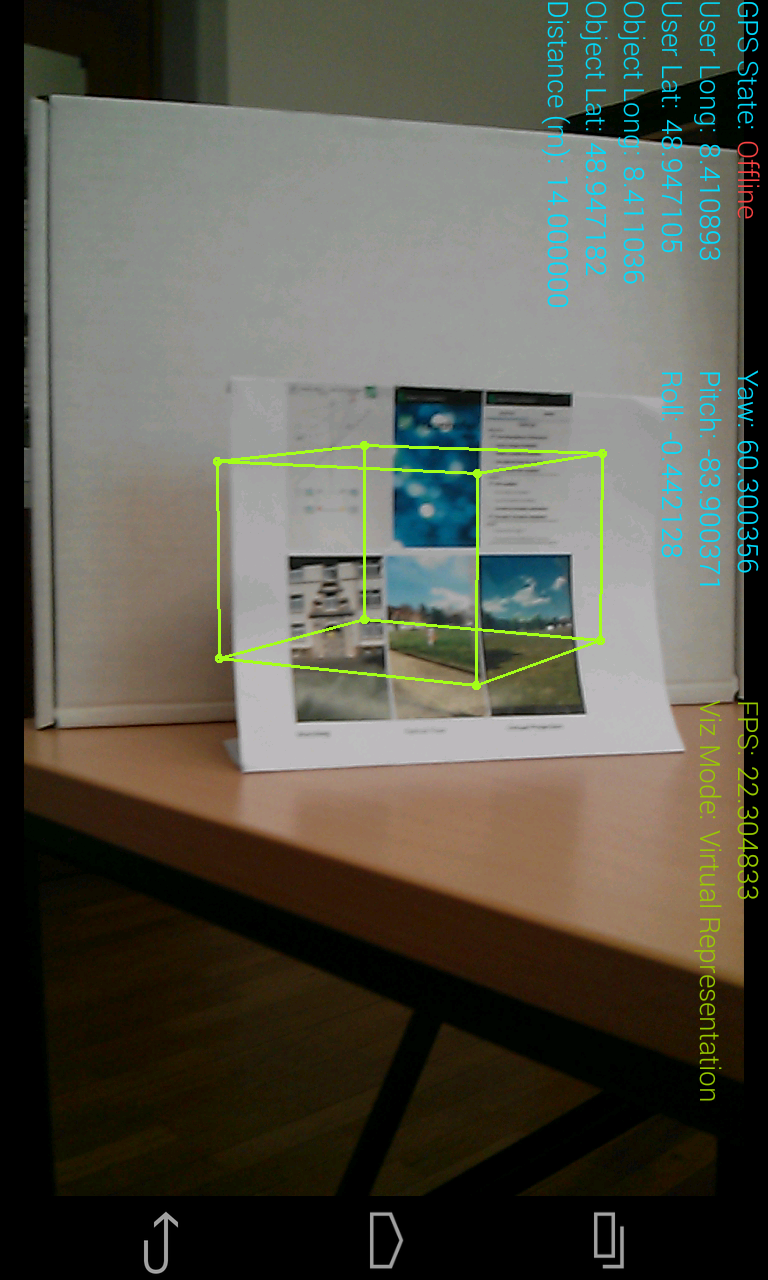

- Augmented Reality Visualisierung (Virtual Representation): Durch die Auswertung der Orientierung des mobilen Endgerätes und dem Wissen über die Standorte von mobilem Endgerät und Objekt wird das Objekt mithilfe von Augmented Reality Techniken im Kamerabild dargestellt. Hierbei wird eine eigens entwickelte virtuelle Umgebung für die Repräsentation des Objekts genutzt.

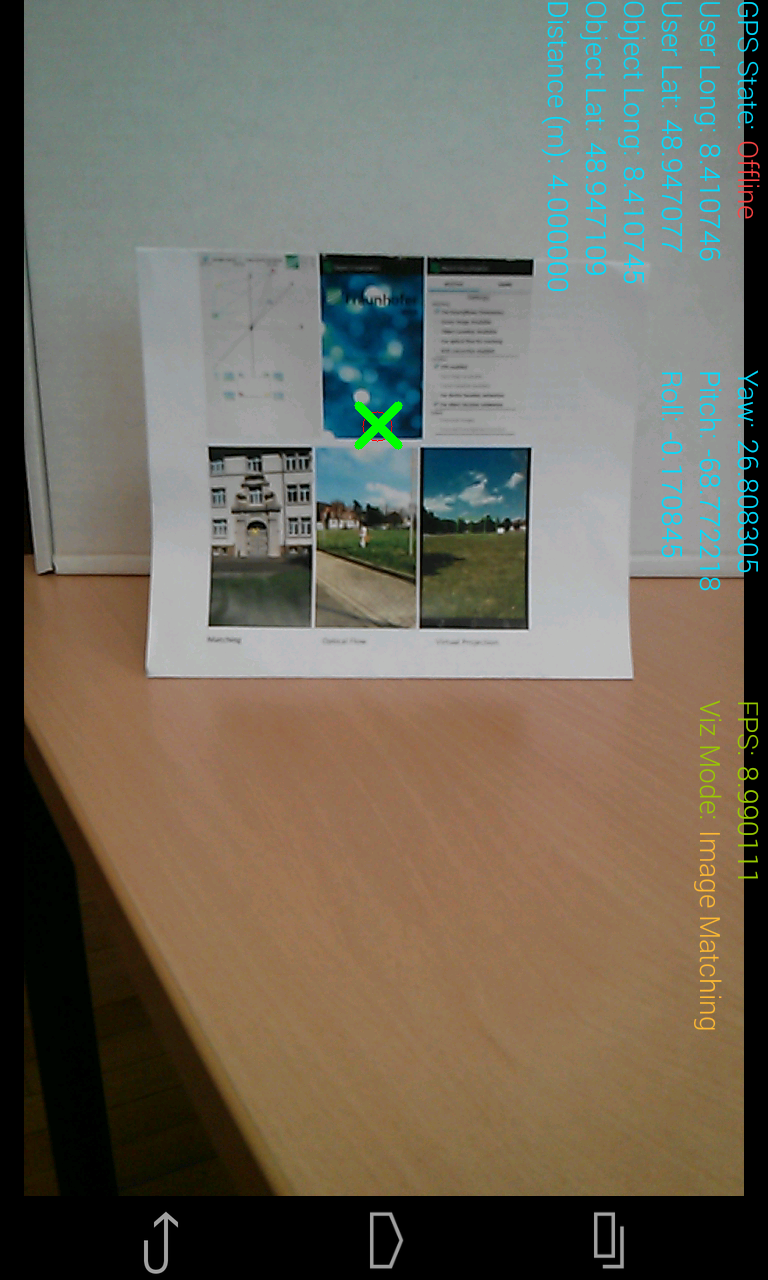

- Objekterkennung: Ist ein Bild des Objekts verfügbar, so kann ein auf Deskriptoren basierendes Matching-Verfahren verwendet werden. Verwackelte Bilder werden hierbei mithilfe der Auswertung der IMU herausgefiltert.

- Objektverfolgung mittels Optischer Fluss Methoden: Ein durch Objekterkennung gefundenes Objekt kann anhand von Optischen Fluss Verfahren in den folgenden Bildern verfolgt werden.

Bei allen Techniken wird durch die Auswertung der Orientierung des mobilen Endgeräts als erstes überprüft, ob sich das Objekt im Sichtfeld befinden könnte. Erst dann werden weitere Visualisierungstechniken angewendet.

Objekterkennung Objektverfolgung Augmented-Reality-Visualisierung

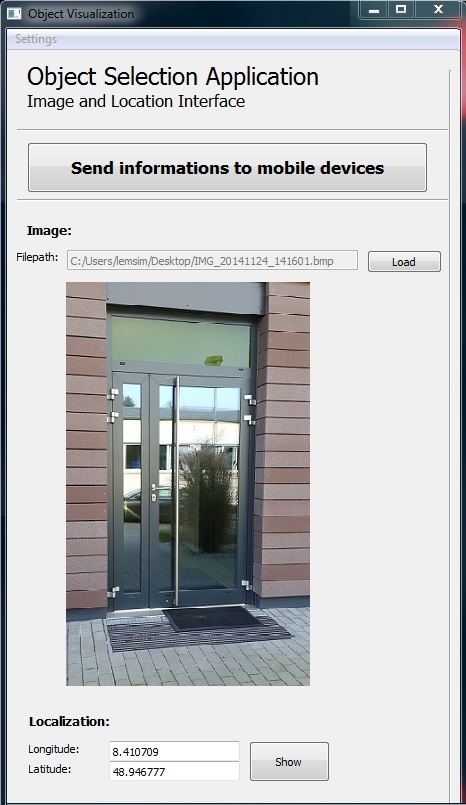

Sowohl eine Desktop Anwendung (Desktop Object Selection Application) als auch eine mobile App (Mobile Object Selection App) ermöglichen die Auswahl eines Objekts. Hierbei wird der Objektstandort gewählt und ggf. ein Bild des Objekts selektiert/aufgenommen. Die Informationen werden im weiteren Verlauf über einen Server an das mobile Endgerät übermittelt.

Das nachfolgende Video zeigt, wie in der mobilen Selektions-Applikation zunächst der Standort des Objekts ausgewählt wird. Als nächstes wird das gewünschte Objekt fotografiert, gefolgt von einer Zusammenfassung der Daten. Die Daten werden nun an einen Server versendet und können in Folge dessen für die Visualisierungs-App verwendet werden.

Desktop-Applikation, in der das Objekt selektiert werden kann.

Publikationen zu diesem Projekt:

1. Simon Lemaire, Christoph Bodensteiner, Michael Arens, "High precision object geo-localization and visualization in sensor networks", Proceedings of SPIE Vol. 8899, 889919 (2013) SPIE Digital Library

2. Simon Lemaire, Christoph Bodensteiner, Michael Arens “Mobile device geo-localization and object visualization in sensor networks” Proceedings of SPIE Vol. 9250, 92500P (2014) SPIE Digital Library

Beteiligte Mitarbeiter:

Dr. rer. nat. Michael Arens

Dr.-Ing. Christoph Bodensteiner

Dipl. Phys. Simon Lemaire

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB