Ausgangssituation; multi-modale Bilddaten unterschiedlichster Sensoren

Die Möglichkeiten zur hochgenauen dreidimensionalen Erfassung der Umwelt mittels bildgebender Sensorik schreiten immer weiter voran. Beispielsweise erlauben moderne Laserscanner-Systeme eine schnelle und äußerst genaue dreidimensionale Erfassung der Umwelt. Meist handelt es sich dabei aber um vergleichsweise teure und unhandliche Systeme. Um diese zumeist schon im Vorfeld gewonnene 3D-Information nun auch mit herkömmlichen Kameras nutzen zu können, muss eine multi-modale Bilddatenfusion stattfinden. Hierbei werden Informationen über die exakten Parameter der eingesetzten Sensoren und deren Lage zur beobachteten Szene bestimmt. Dies erlaubt in der Folge eine Ableitung der 3D-Struktur von korrespondierenden Bildinhalten und bietet die Möglichkeit zur direkten Markierung und Annotation von Objekten im Kamerabild.

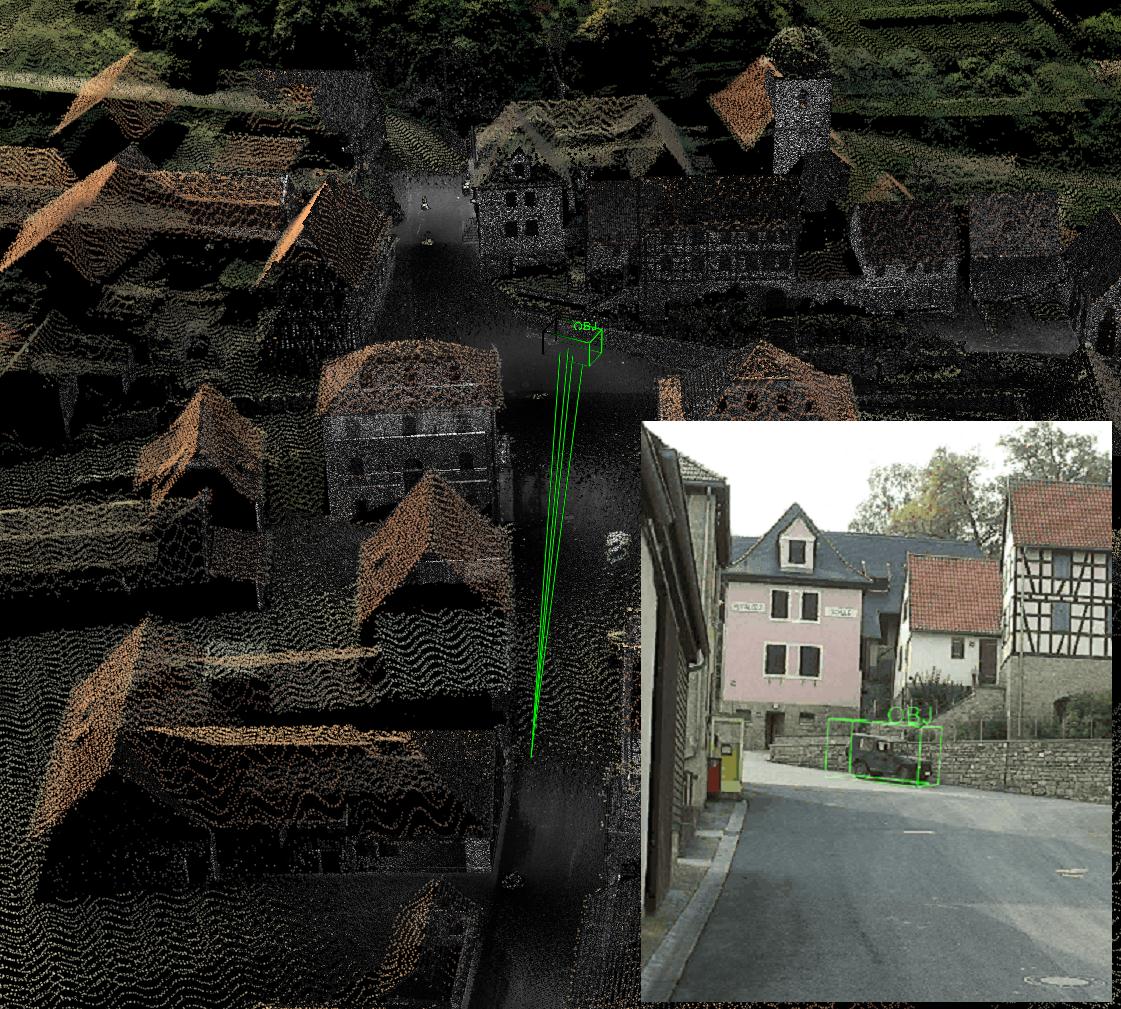

Visualisierung eines 3D-Laserscans (fusionierte Daten von terrestrisch und luftgetragen akquirierten Laserscans) mit der errechneten Objektposition des im Kamerabild (rechts unten) definierten Objekts.

Aufgabe

Das Ziel des Projekts sind generische Verfahren zur dreidimensionalen Objektlokalisierung, welche sowohl mit herkömmlichen Bildinformationen im sichtbaren Spektrum als auch mit Bilddaten aus anderen Spektralbereichen operieren und auf im Vorfeld aufgenommene 3D-Daten zurückgreifen können. Die Einsatzgebiete reichen von der genauen Positions- und Orientierungsbestimmung von Kameras und den darin abgebildeten Objekten bis hin zu verbesserten 3D-Trackingverfahren und Augmented-Reality Anwendungen.

Ergebnis

Im Rahmen des Projektes wurden hierzu hochgenaue Registrierungsverfahren für Bilddaten im sichtbaren und infraroten Spektralbereich entwickelt, welche mit terrestrischen und luftgetragenen 3D-Laserscanning Daten eingesetzt werden können.

Projektbeschreibung

Eine wichtige Grundlage der entwickelten Fusionsalgorithmen stellen dabei neue Verfahren zur multi-modalen Korrespondenzfindung und intensitätsbasierten Bildregistrierung dar. Eine wichtige Eigenschaft der Verfahren ist die Möglichkeit zur direkten Verwendung von 3D-Laserscans. So können zeitnah akquirierte 3D-Daten ohne aufwendige und meist fehleranfällige Vorverarbeitung direkt zur Referenzierung herangezogen werden.

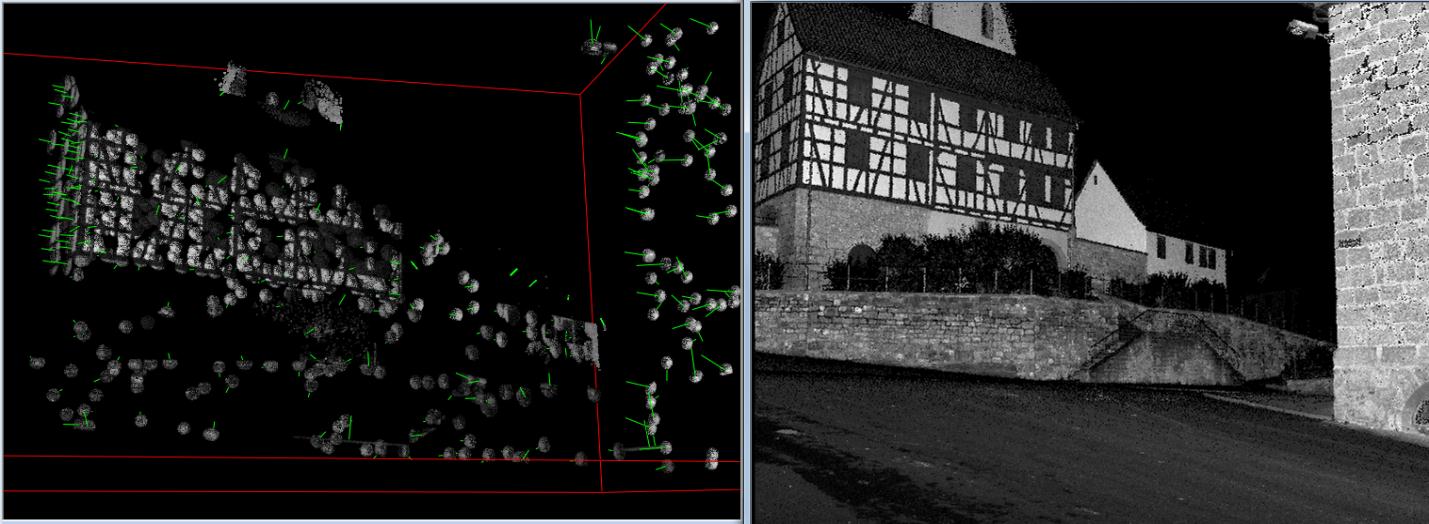

Links: Extrahierte 3D-Regionen mit hohem Informationsgehalt für die Wiedererkennung. Sie bilden die Grundlage für die Erstellung von Merkmals-Landkarten. Rechts: Zugrunde liegender 3D-Scan eines terrestrischen Laserscanners.

Allen Anwendungen gemeinsam ist der Anspruch auf eine vollautomatische Fusion aller beteiligten Datensätze. So sollen die Methoden ohne zusätzliche Sensorik auskommen und auch auf mobilen Geräten einsetzbar sein.

Im Falle größerer Umgebungsmodelle, wie beispielsweise Laserscans größerer Gebiete oder ganzer Städte, spielt hierbei die kompakte und sucheffiziente Repräsentation der 3D-Daten eine wichtige Rolle.

Mittels der Generierung virtueller Kameraansichten und der Extraktion visuell distinktiver Merkmale in den zugehörigen Intensitätsdaten der 3D-Daten (z.B. Laser-Reflektanzwerte) werden die Umgebungsmodelle für die 2D-Erkennung aufbereitet. Hierzu werden hierarchisch gegliederte und mit schnellen Suchstrukturen versehene Merkmalslandkarten generiert, welche eine schnelle Korrespondenzfindung ermöglichen.

Aufgrund der oftmals fundamental unterschiedlichen Objekterscheinungen in multi-modalen Datensätzen werden hierzu robuste Korrespondenzfindungsalgorithmen eingesetzt, die auch die korrekte geometrische Anordnung korrespondierender Merkmale einbeziehen.

Für höchste Genauigkeitsansprüche kann mittels einer nachgeschalteten, intensitätsbasierten Abstandsminimierung zwischen simulierten Ansichten und den Anfrage-Bildern eine hohe Registrierungsgenauigkeit erreicht werden. Neben herkömmlichen statistischen Distanzmaßen werden hier auch neu entwickelte Verfahren auf Basis von Selbstähnlichkeiten verwendet, die eine hohe Robustheit gegenüber lokalen Intensitätsfluktuationen aufweisen.

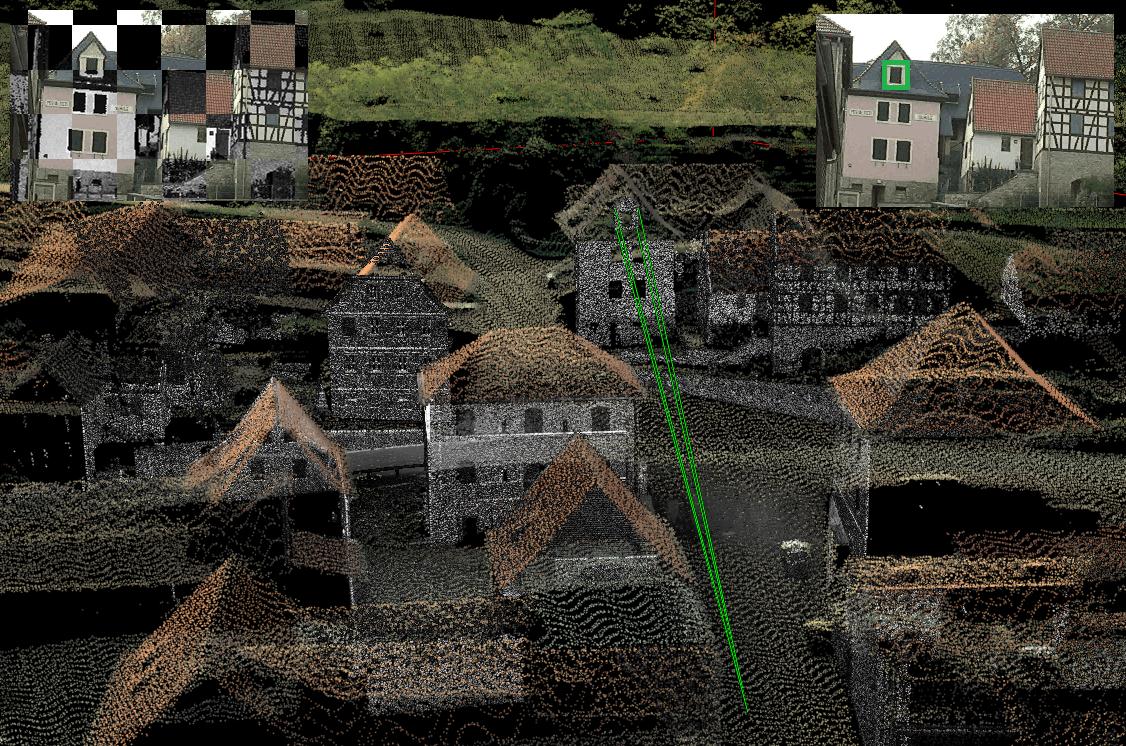

Visualisierung eines 3D-Laserscans (fusionierte Daten von terrestrisch und luftgetragen akquirierten Laserscans) mit den errechneten Sichtstrahlen des im Kamerabild (oben rechts) eingezeichneten Fensters. Links oben: Die Registrierung der multi-modalen Daten bildet dabei die Grundlage für das Referenzieren von Objekten im Bezug zum 3D-Laserscan.

Auf der Basis der bisher entwickelten Verfahren zur multi-modalen Bilddatenfusion sind bereits jetzt viele Anwendungen denkbar.

So kann mittels der zugrundeliegenden 3D-Daten eine kombinierte Auswertung von Sensoren erfolgen, die keine direkten Korrespondenzen zwischen den jeweiligen Bilddaten aufweisen.

Darüber hinaus lassen sich die Laserscans auch als virtuelles Kalibrierobjekt verwenden, um die Ableitung aktueller 3D-Informationen aus bewegten Sensoren zu verbessern. So wird durch die 3D-Daten eine robustere Schätzung der Eigenbewegung ohne zusätzliche Sensorik möglich, was sehr billige Sensorsysteme und kompakte Bauformen ermöglicht.

Veröffentlichungen

- Bodensteiner, C., Hebel, M., Arens, M.: Accurate Single Image Multi-Modal Camera Pose Estimation. ECCV – RMLE, 2010.

- Bodensteiner, C., Huebner, W., Juengling, K., Mueller, J., Arens, M.: Local Multi-Modal Image Matching Based on Self-Similarity, IEEE - ICIP, 2010.

- Bodensteiner C.: A Situation Awareness and Information Handover System for Small Unit Operations, Trilateral-Workshop (SE-NL-DE) Team Situation Awareness in Small Unit Operations, Stockholm, 2011.

- Bodensteiner C., Hübner W., Jüngling K., Solbrig P., Arens M.: Monocular Camera Trajectory Optimization using LiDAR Data, Computer Vision in Vehicle Technology (CVVT), ICCV, Barcelona, 2011.

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB