Kurzbeschreibung des Projekts

Auch in automatisierten Fahrzeugen müssen die Fahrenden in Zukunft noch kurzfristig oder von Zeit zu Zeit an Systemgrenzen die Fahraufgabe übernehmen. Studien zeigen, dass die Übernahmefähigkeit der Fahrenden dabei unter anderem von deren Aktivität abhängt. Um eine sichere Übergabe zu gewährleisten muss das Fahrzeug deshalb wissen, in wie weit der Fahrende überhaupt in der Lage ist, das Steuer zu übernehmen und wie lange diese Übernahme voraussichtlich dauern wird.

Dieses Beispiel steht stellvertretend für viele weitere Anwendungsfälle, in denen die Mensch-Maschine-Interaktion davon profitiert, wenn das maschinelle System in die Lage versetzt wird, Nutzende wahrzunehmen und deren Aktivität semantisch erkennen bzw. nachvollziehen zu können. Grundlegend geht es dabei um die Bearbeitung der Frage: Womit ist der Nutzer oder die Nutzerin momentan beschäftigt? Kann das Assistenzsystem Nutzende in irgendeiner Weise unterstützen? Und wenn ja, worauf muss oder kann es Bezug nehmen, um intuitiv aber auch proaktiv Unterstützung anzubieten?

Projektziele

Das zugrunde liegende Ziel einer Aktivitätserkennung, also zu erkennen, womit Nutzende momentan beschäftigt sind, kann auf unterschiedliche Weise und mit unterschiedlicher Granularität erreicht werden. Naheliegende Herangehensweisen beschränken sich zunächst auf die Beobachtung von Kopf und Augen. Bei ausreichend großen Aufmerksamkeitszielen kann allein aufgrund der Kopf- und Augenbewegungsmuster zwischen aufmerksamen und unaufmerksamen Personen unterschieden werden. Soll zum Beispiel unterschieden werden, welche Person in einem Gespräch unter mehreren Personen angesprochen wird, kann in vielen Fällen allein anhand der Kopfdrehung eine verlässliche Aussage getroffen und somit auch nachvollzogen werden, ob jemand seine Aufmerksamkeit abwendet.

Allerdings kommen solche Systeme schnell an ihre Grenzen, wenn nicht nur zwischen betrachteten Aufmerksamkeitszielen, sondern auch zwischen verschiedenen Objekten unterschieden werden muss, mit denen eine Person agieren kann. Für viele Nebentätigkeiten sind darum insbesondere auch Handbewegungen von großer Bedeutung. Ergänzend zur Kopfdrehung bzw. Blickrichtung bietet sich hierbei eine Erfassung der Hände an, um Interaktionen, Manipulationen oder andere handwerkliche Tätigkeiten in die Aktivitätsklassifikation einfließen zu lassen. Im Fahrzeuginnenraum lässt sich so anhand der Handbewegung und ergänzender Objekterkennung der oder die schlafende Fahrer:in von einem am Handy tippendem Insassen unterscheiden.

Die klassische Aktivitätserkennung sucht den Kompromiss, indem nicht generativ Einzelinformationen aus den Bildern extrahiert und zu einem semantischen Bildverständnis vereint werden, sondern indem die Bildsequenzen als Ganzes Situationsklassen zugeordnet werden. Heutzutage kommen hierzu oft 2D oder 3D Convolutional Neural Network s (CNNs) oder Rekurrente Neuronale Netze zum Einsatz.

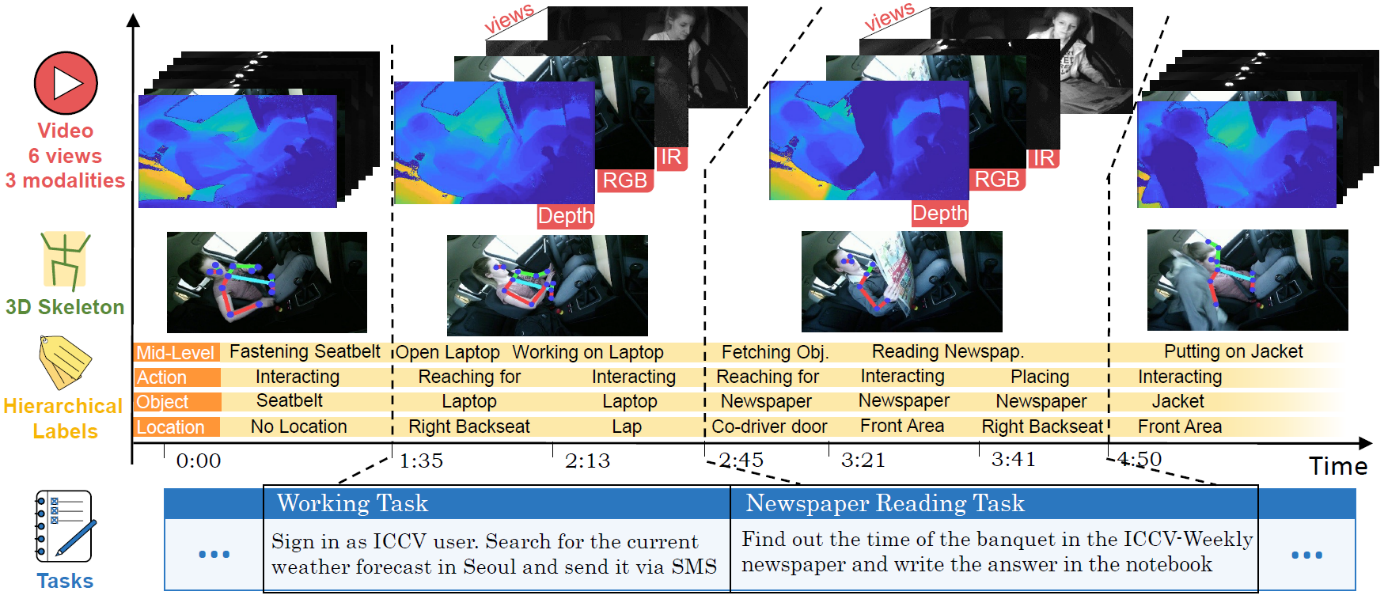

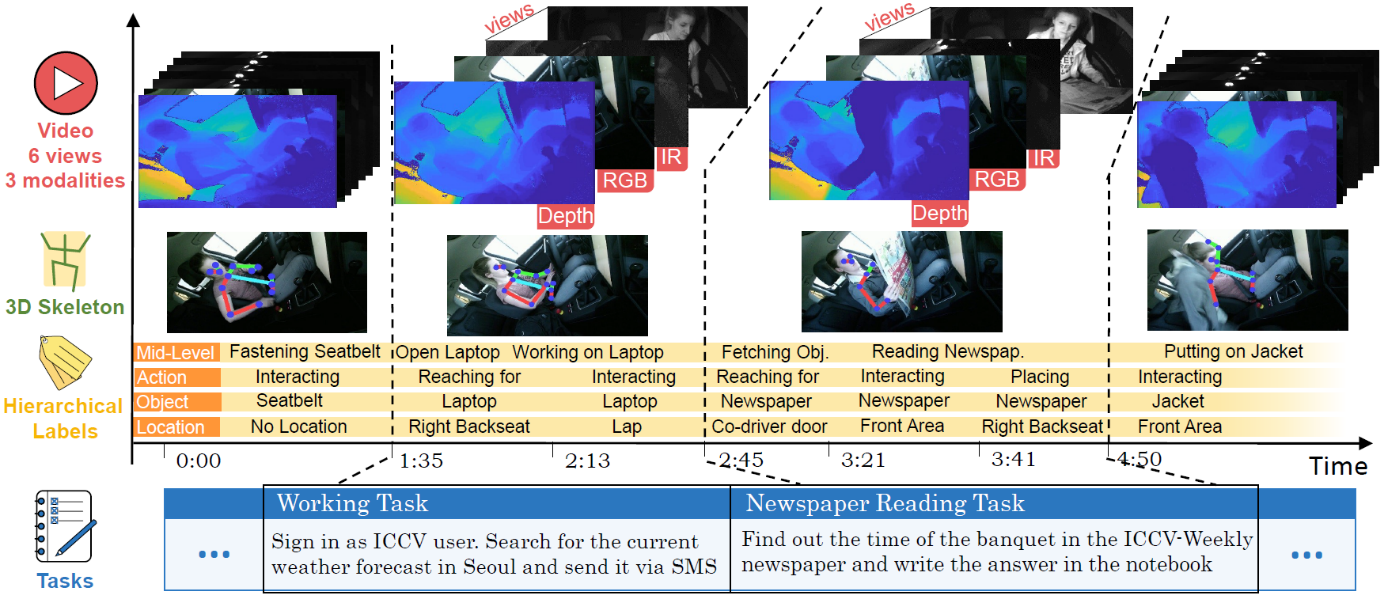

Das Fraunhofer IOSB setzt die Aktivitätserkennung insbesondere im Produktionsumfeld sowie im Fahrzeuginnenraum ein. Aus dem vom BMBF geförderten Forschungsprojekt PAKoSgeht der öffentlich verfügbare Datensatz „Drive&Act“hervor, in welchem Nebentätigkeiten von Fahrzeuginsassen kamerabasiert aufgezeichnet und multihierarchisch zu Nebentätigkeit zugeordnet wurden. Hierbei wurde durch die Verwendung von Nahinfrarot, Tiefen und Farbkameras auf ein vielfältiges aber auch realistischen Sensorsetup geachtet. Insgesamt beinhaltet der Datensatz mehr als 9 Millionen Videobilder und wurde mit einer Hierarchie aus insgesamt 83 Klassen manuell annotiert.

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB

Fraunhofer-Institut für Optronik, Systemtechnik und Bildauswertung IOSB